音声生成AIとフェイク検知の未来

- 4 日前

- 読了時間: 10分

こんにちは。NABLAS R&D事業部です。

ChatGPT や Gemini をはじめとするテキスト生成AIが日常に浸透してきた2025年、私たちはAIとの会話と共に暮らし始めています。画面に文字が並ぶだけでなく、声を聞くことでの対話体験も今後さらに加速していくでしょう。

音声生成技術( TTS : Text-to-Speech )は、これまで「読み上げ」の用途が中心でした。しかし、最近の音声生成技術は音の出力だけでなく、「誰が、どのように話すか」を再現する、声の創造へと進化しています。

数秒の音声から個人の声を再現し、さらに多言語で喋らせることや、話し方に感情を含ませ、個性や文脈を感じさせることも可能になってきました。

本記事では、NABLASで研究開発中の音声生成の技術の基本構造から最新トレンドをはじめ、社会実装までをご紹介します。

目次

音声フェイク検出の社会実装

音声生成AI技術の活用例

CoeFont

音声生成技術に強みを持つ CoeFont は、 ⻘二プロ所属と連携して著名声優の声をAIに学習させ、音声サービスを展開しています。声優を指定してセリフを文章で入力すると、実際にその声優が話しているような音声を英語や中国語などで出力できます。音声ナビゲーションなどでの利用を見込んでおり、アニメや映画の吹き替えといった演技目的ではサービスを提供していません。

また、CoeFont では、声帯摘出者による CoeFont CLOUD というサービスも展開しています。今後、声帯摘出手術などにより声を失う可能性のある方が自分の声を収録することで、声を失ったあともスマホやPCから簡単な文字入力で自分の声で音声合成が使用できるサービスです。従来の1文字ずつ繋げて音声にするサービスとは異なり、本人が話しているような音声を生成する事ができます。

音声生成AI技術の悪用事例

音声生成AIがサービス化する中で著名人や芸能人、政治家や警察、自動音声の声を用いることで武断利用をはじめとするトラブルや事件に発生することも少なくありません。2024年には、声優などの業界団体がAIで声優の声を利用する際には本人の承諾を得ること・AIの音声であることを明記することなどを求める声明を発表しました。この団体によると、現在、アニメキャラクターの声で好きな歌を歌わせるなど、無断で作成された音声などがネットに公開されていたり、販売されたりするケースが確認されています。

音声生成AI技術の開発例

国産音声生成AI技術の発展

国内生成AI開発プロジェクト「GENIAC」の第1.5期と第2期に採択されたKotoba Technologies Japan。最先端の日本音声モデル「 Kotoba SpeechGen 」β版をリリースしています。 音声生成技術においては、世界的企業と比較してプロフェッショナルユーザーから高評価を得ています。CES2025 における観光ガイドアバターの音声に採択が決定、キャラクターボイスを活用した観光案内の実現に向けて開発を進めているとのことです。

NABLASでの音声生成技術

NABLASのR&D事業部でも、様々な最新の音声合成技術や日本語に対して強いモデルを開発しています。

音声合成・音声生成AI技術

音声合成技術 ( TTS : Text-to-Speech )

テキスト(文字情報)を入力として受け取り、音声波形に変換する技術で、人間が話しているような音声を人工的に作ることができます。一般的な処理の流れは以下の図の通りです。

音響モデルは、音声の抑揚やイントネーションを学習し、入力されたテキストから音響特徴量を抽出し、メルスペクトログラムや基本周波数F0などのデータを出力します。また、音響モデルには自己回帰( AR : Auto-Regressive )モデルと非自己回帰( NAR : Non-Auto-Regressive )モデルという、大きく2つの手法があります。

ボコーダーは、音響モデルが出力したメルスペクトログラムや基本周波数F0などのデータを、実際に耳に聞こえる自然な音声波形へと変換します。

音響モデルとボコーダーを別々に設計・学習する手法以外に、End-to-Endモデルと呼ばれる「テキストから音声波形までを一貫して学習・生成する手法」も登場しています。音響モデルとボコーダーを使う従来方法と比べ、自然でリアルな音声を高速に生成可能ですが、一部のモデルでは計算コストが高くなります。コスト、カスタマイズ性においては従来方法の方が適している場合もあることから、従来方法との住み分けが必要です。

音声生成 ( Speech Generation )

音声合成や音声変換も音声生成の一種ですが、中でもニューラルネットワークを活用した手法では、より自然な音声を人工的に生成することができます。

音声合成と音声生成の違い

音声生成AI技術の歴史

音声生成技術は、ここ数年で大きな進化を遂げています。

1980年以前は波形接続方式をはじめとするルールベース手法が主流でした。本物の音声を繋ぎ合わせるため、高品質でしたがイントネーションの表現や柔軟性に欠ける部分がありました。

1990年代に入ると、隠れマルコフモデル( HMM )により、音声の時間変化を確率モデルで表現できるようになりました。ルールベース手法よりも柔軟性はありますが、音声の自然さに関しては劣っています。

2010年代には WaveNet と呼ばれる、ディープラーニングを用いた音声生成が誕生しました。音声波形を直接生成し、自然な音声の生成が可能となりました。その後、GAN や VAE などの技術により、多様な音声生成が可能となりました。

2020年から現在においては Transformer や拡散モデルを活用し、ノイズの付加・除去を通した生成が可能になりました。さらに SoundStorm と呼ばれる生成モデルでは、非常に高品質な音声を高速に生成することが可能となりました。

音声生成における拡散モデルの役割

拡散モデルは、データにノイズを加えてランダム化し、そのノイズを徐々に取り除いて元のデータ を生成する生成手法です。ノイズを加えることで、モデルがデータの確率分布をより広く学習し、高品質な音声を生成できます。WaveGrad、DiffWave、Grad-TTS などのモデルがあります。

音声フェイク検出技術

音声フェイク検出技術の現況

日本国内では検出技術の実用化事例が少なく、NABLASが国内では初となるディープフェイク音声の検出技術を実用化し、サービス提供を開始しました。

海外では Pindrop による、AIが生成した音声を99%の精度で検出するウェブベースのツール「 Pulse Inspect 」や、マカフィーによる、ディープフェイクを検知するブラウザ拡張機能「 Deepfake Detector 」などが発表されています。

音声フェイク検出の技術的アプローチ

音声検出モデルは、主に特徴抽出器と分類器から構成され、これを Hardcraft 型モデルと呼びます。近年では、特徴抽出から分類までを End-to-End で行うモデルも注目されていますが、どちらのモデルにも一長一短があります。

音声検出の基本的な流れは、録音環境のちがいや雑音の影響を減らすことで、音声検出の精度を向上させる前処理、前処理した音声データから、人の声かフェイク音声かを区別するための特徴を抽出する特徴抽出、機械学習を用いて Real / Fake を見分ける分類の3つのステップからなります。

ノイズ除去

Wiener フィルタ(雑音だけを除去)

バンドパスフィルタ(特定の周波数のみを通す)

正規化

異なる録音条件の影響を考慮

音量などのばらつきを統一

検出制度を安定させる目的

分割

連続値である音声データを短い時間区間(フレーム)に分割

小さいフレーム単位にすることで、特徴をより捉える

バンドワイズ

特定の周波数帯域毎に処理を行う

ノイズ除去や音声強調など特徴の精度を向上

周波数特徴 音声の周波数分布を抽出する

MFCC(メルケプストラム係数)

スペクトログラム

ピッチ特徴 声の高さや抑揚、変動パターンを解析

基本周波数

ピッチ変動の周期性

位相情報 音波がどのタイミングで開始されるか

STFT(短時間フーリエ変換)

従来型モデル

音響特徴量に基づくルールベースや統計的な検出方法

機械学習をベースにした方法( SVM、ランダムフォレスト )

ディープラーニング型モデル

CNN や LSTM

Transformer や逆生成的手法

ハイブリッド型手法も存在

主な検出モデルの特徴比較

音声フェイク検出の新しい技術的アプローチ

LEAF( Learnable Fronted:学習可能なフロントエンド)

ニューラルネットワークによって最適なフィルタを自動学習する

音声の前処理で、モデルがデータに基づいて最適な特徴を抽出

ドメインに特化した、音声解析の精度を向上させることを目的とし、音声データに最適化された特徴量の抽出に長けています。音声認識、感情分析、スピーカー認識などに適応できますが、モデルの学習に大量のデータと計算資源が必要になるケースがあります。

Wav2Vec

自己教師あり学習を用いて、音声データから特徴量を抽出

大量のデータによって事前学習された高品質なモデルが公開

生の音声波形を入力し、End-to-Endで特徴量を学習します。Transformer を採用しているため、より高度な特徴量抽出が可能ですが、モデルの複雑さに加えて計算資源を多く使用することから、現段階では実装や運用のハードルが高くなっています。

AASIST ( Audio Anti-Spoofing using Integrated Spectro-Temporal Graph Attention Networks )

Graph Attention Network ( GAT ) を活用し、スペクトルと時間領域に存在するフェイク音声の特徴を捉える

AASISTは単一のモデルで End-to-end で検知することを目指している

スペクトラムと時間領域の異なる特徴を同時にモデル化することができますが、モデルに含まれるパラメータ数が大きく、学習と推論に大量の計算資源が必要となります。

ASSERT ( Anti-Spoofing with Squeeze-Excitation and Residual neTworks )

Squeeze-Excitation ( SE ) ブロックと ResNet を組み合わせた、音声検知に特化したモデル

テキスト読み上げ、音声変換、リプレイ攻撃といった様々な攻撃手法に対応]

汎用性が高く、多様なフェイクに対して高い検知精度を記録しています。しかし、モデル構造が複雑であることから、実装やチューニングに専門的知識が必要となります。

音声フェイク検出における課題

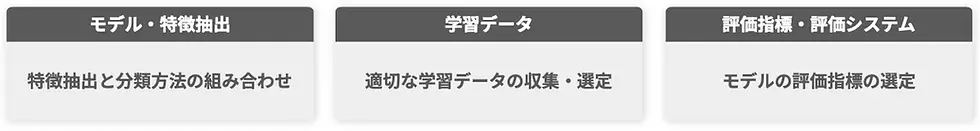

音声検出技術にはいくつかの課題がありますが、大きく下記の3つに分類することができます。

特徴抽出と分類方法の組み合わせ

最新の生成技術が次々に登場する中で、汎化性能や実用性も踏まえた特徴量の抽出方法と分類モデルの選定が課題となっています。

MFCCとLFCC、ピッチ特徴と位相情報、Hardcraft 型モデルと End-to-End モデルなどあらゆる特徴抽出方法や分類器選定の組み合わせが多く存在し、選択によって精度が大きく変化します。タスクに応じた選定と組み合わせを考慮する必要があります。

適切な学習データの収集・選定

最新の生成技術を含めたデータを偏りなく収集‧生成し、様々な環境を想定して未知の音声にも対応可能な学習が必要です。

様々な環境下の人間の音声データの収集だけでなく、ボイスチェンジャーによる加工を施された音声や、TTS音声などあらゆる音声データが必要となります。また、スマートフォン・IP電話・会議電話などの録音環境への対応や、投資誘導・なりすまし・偽情報拡散などのユースケースに合わせた対応も必要です。

モデルの強化指標の選定

実ユースケースに合わせて特化した評価データセットや、評価方法を構築する必要があります。単純な正答率のみでなく、誤検知率や未知データでの評価など多面的な評価が重要です。

音声フェイク検出の社会実装

音声生成技術は日々進化しており、最新の生成AI技術を検出できるモデルの開発が必要となります。新たなアルゴリズムの開発はもちろん、検出精度を向上させる大規模データと計算資源、より最新で最適な検出基盤を維持するためのデータセントリック基盤が不可欠です。

さらに、多様なフェイク音声を用いた攻撃シナリオを考慮する必要があります。今までの広範囲な拡散から、なりすまし・音声詐欺など個人を標的とした攻撃も増えています。幅広いシナリオに対応できるよう、環境や話者など条件の異なる多様な音声データセットの構築が必要です。